この記事は以下の論文を紹介し、その上でディープラーニングについて説明したものです。

Geoffrey E Hinton, Simon Osindero, Yee-Whye Teh,”A fast learning algorithm for deep belief nets”

論文の概要

ジェフリー・ヒントンらが2006年に発表した「A Fast Learning Algorithm for Deep Belief Nets」は、深層学習モデルに革新をもたらしました。この論文では、多層ニューラルネットワークである「深層信念ネットワーク(Deep Belief Nets: DBN)」を効率的に学習するための新しいアルゴリズムを提案しています。

従来のディープネットワークでは、隠れ層が増えるほど計算負荷が増大し、推論が困難になる問題がありました。ヒントンらはこの課題に対して、「相補的な事前確率(complementary priors)」を導入し、推論を簡素化し、各層を効率的に学習する「貪欲法」を開発しました。この手法により、深い構造でも効果的に学習が可能となりました。

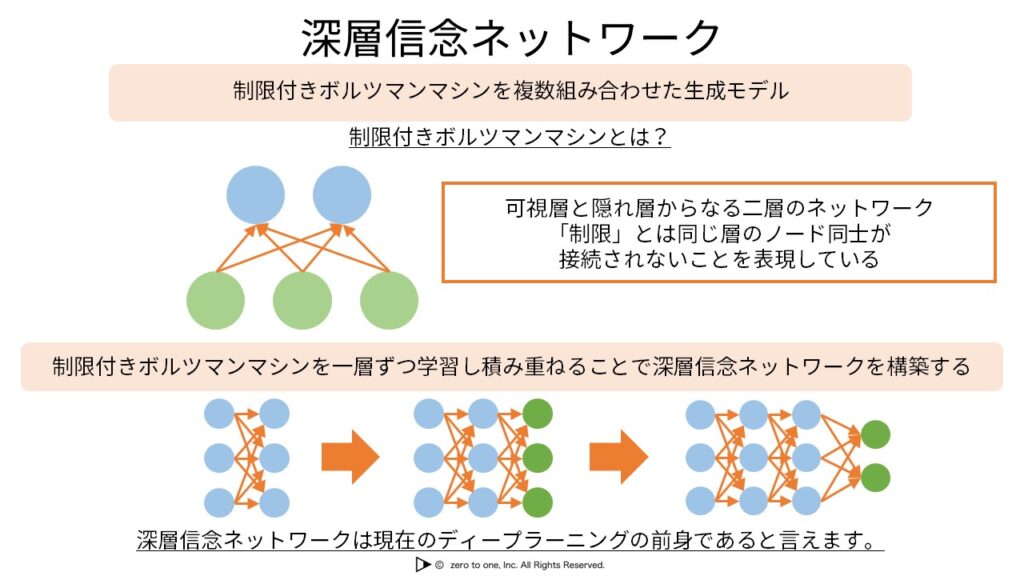

論文では、制限付きボルツマンマシン(Restricted Boltzmann Machine: RBM)を用いて各層を独立に学習する方法も紹介されています。このアプローチは、現在のディープラーニングにおける重要な基盤となっています。RBMを利用することで、各層を独立に最適化し、全体の効率性を高めました。

この研究は、ディープラーニングの基礎を築き、深層信念ネットワークと貪欲法が今なお影響力を持ち続けていることを示しています。これらの手法は、AI技術の発展に重要な役割を果たしました。

深層信念ネットワークの登場

2006年、ジェフリー・ヒントンらによって発表された「A Fast Learning Algorithm for Deep Belief Nets」という論文は、ディープラーニングの進化に大きな貢献を果たしました。この論文は、ディープラーニングにおける計算負荷や推論の難しさといった主要な課題を克服し、新たなアルゴリズムを提案することで、多くの研究者や技術者に影響を与えました。ジェフリー・ヒントンは、ディープラーニングの分野における先駆者であり、ニューラルネットワークの発展に多大な貢献をしました。

この論文では、相補的な事前確率(complementary priors)を用いて「説明の排除(explaining away)」の現象を緩和し、効率的に学習を行う「貪欲法」を提案しています。この手法により、深層信念ネットワークの各層を順次学習することが可能となり、ディープラーニングの発展を後押ししました。

さらに、この研究を通じて深層学習の可能性を広げただけでなく、他の研究者が深層学習技術を応用・拡張する基盤を築きました。その結果、ディープラーニングはさまざまな分野に応用され、画像認識、音声認識、自然言語処理など、幅広い分野での発展が促されました。

この論文は、多層のニューラルネットワークを効率的に学習させるための革新的なアルゴリズムを提案しています。当時、ディープラーニングには計算負荷が高く、推論が困難であるという課題があり、深いネットワークの学習には多くのリソースと時間が必要でした。この研究では、「相補的な事前確率(complementary priors)」の概念を導入し、隠れ層の効率的な学習を可能にする手法を開発することで、深層信念ネットワーク(Deep Belief Nets: DBN)のような複雑なモデルの学習を大幅に効率化しました。

この「深層信念ネットワーク(DBN)」により、ディープラーニング技術は一段と実用的で強力なものとなり、多層ネットワークの学習がより現実的になりました。また、制限付きボルツマンマシン(Restricted Boltzmann Machine: RBM)を使用して各層を独立に学習する方法を示し、階層ごとにモデルの性能を改善できることを強調しています。この革新は他のモデルやアルゴリズムにも応用され、ディープラーニング全体の技術的発展を促しました。

この研究は、ディープラーニングがAIの中心的な技術となるための基盤を築きました。これにより、複雑なタスクを効率的に解決することが可能となり、多くの分野でAI技術の進展が加速されました。この記事では、この革新的な研究がディープラーニングの進展にどのように寄与したのかを解説します。具体的には、このアルゴリズムがどのようにディープラーニングの性能を向上させ、どのようにして今日のAIの進化に影響を与えたのかを説明します。

ディープラーニングの基礎と課題

ディープラーニングの基礎

ディープラーニングは、機械学習の一種で、多層のニューラルネットワークを使ってデータのパターンを学習する方法です。この技術は、画像認識や音声認識、自然言語処理など、さまざまな分野で大きな進歩をもたらしました。ここでは、ディープラーニングの基本的な仕組みについて簡潔に説明します。

ディープラーニングの基礎にあるのがニューラルネットワークです。これは人間の脳を模倣した計算モデルで、複数の「層」を通じてデータを処理し、学習します。層には入力層、隠れ層、出力層があり、特に隠れ層が多いと「ディープ(深い)」なネットワークと呼ばれます。

ディープラーニングは、多くの現実的な問題に役立っています。例えば、画像認識では物体の検出や分類、音声認識では音声をテキストに変換する用途に利用されています。また、自然言語処理では、自動翻訳やチャットボットのような応用が進んでいます。

ディープラーニングにおける主要な課題

ディープラーニングの進化とともに、さまざまな課題も明らかになりました。ここでは、その中でも特に重要なものを紹介します。

計算負荷とリソースの消費

ディープラーニングには高い計算負荷が伴います。そのため、強力なハードウェアやGPUが必要であり、高いコストが課題です。特に、深いモデルほど学習に時間とリソースがかかります。

データ依存と品質

ディープラーニングモデルには大量のデータが必要です。しかし、データに偏りがあると、モデルも偏った判断をするリスクがあります。その影響は特に医療や法務などの分野で深刻です。

解釈性の欠如

ディープラーニングモデルは「ブラックボックス」と呼ばれ、その内部の判断プロセスを理解するのは難しいです。このため、重要な意思決定における信頼性が損なわれることがあります。

過学習(オーバーフィッティング)

ディープラーニングは、トレーニングデータに過度に適合してしまう「過学習」の問題が発生することがあります。これにより、新しいデータに対する性能が低下します。

まとめ

これらの課題に対し、さまざまな対策が提案されています。計算負荷については、新しいハードウェアや効率的なアルゴリズムの開発が進んでいます。また、データの品質向上には、データ前処理技術が利用され、「説明可能なAI(XAI)」の研究も進行中です。

今後、ディープラーニングをより広く活用するためには、これらの課題を克服することが不可欠です。技術の進展により、より使いやすく、幅広く利用できるAIの登場が期待されています。

深層信念ネットワーク(Deep Belief Nets: DBN)の革新

深層信念ネットワーク(Deep Belief Nets: DBN)は、ディープラーニングの初期に重要な役割を果たしたモデルです。DBNは複数の層から成るニューラルネットワークで、データから複雑なパターンを学習します。2006年にジェフリー・ヒントンらによって提案され、ディープラーニングの基礎を築いた技術の一つです。

出典: zero to one,” 深層信念ネットワーク”

構造と仕組み

DBNは、複数の制限付きボルツマンマシン(Restricted Boltzmann Machines: RBM)を積み重ねて構築されます。各RBMは層ごとに独立に学習し、その結果として深い特徴を抽出できます。この階層的な学習構造によって、モデルはデータから段階的に抽象的な特徴を学び、深い理解を得ることができます。

貪欲法

DBNの特徴の一つは「貪欲法」です。このアルゴリズムはネットワークを一層ずつ学習し、各層がRBMとしてまず学習し、その後に全体のネットワークを微調整します。これにより、深層ニューラルネットワークの学習が効率的に行えるようになり、深い構造のモデルでも現実的に利用可能となりました。

DBNの応用と利点

DBNは、ディープラーニングの初期に多くの応用がありました。特に、画像認識や音声認識といった複雑なデータから特徴を学ぶタスクで強力なツールとして活用されました。

画像認識

DBNは、画像認識で効果的に使われました。特に物体の特徴を抽出するのに優れており、各層が画像から段階的に抽象化された特徴を学習することで、物体を正確に認識することができます。

音声認識

音声認識でも、DBNは大きな成果を挙げました。音声データから段階的に特徴を学習し、ノイズの影響を受けにくい表現を獲得することで、より正確な認識が可能になりました。

DBNの限界とその後の発展

DBNはディープラーニングの発展に大きく貢献しましたが、いくつかの限界もありました。特に、計算負荷が高いことや、深いモデルの学習には大量のデータが必要であることです。

計算の複雑さ

DBNは学習に多くの計算リソースを必要とします。層が深くなるほど計算は複雑化し、モデルのトレーニングに多くの時間とリソースがかかるという課題があります。

後続モデルへの道筋

これらの限界を克服するために、新しいディープラーニングのアーキテクチャが開発されました。例えば、畳み込みニューラルネットワーク(Convolutional Neural Networks: CNN)やリカレントニューラルネットワーク(Recurrent Neural Networks: RNN)は、DBNが持つ問題点を克服し、さらに高い性能を発揮しました。DBNはこれら後続のモデルの基礎を築き、ディープラーニングの進化を支える重要なステップとなりました。

まとめ

深層信念ネットワーク(DBN)は、ディープラーニングの進化を支えた重要な技術です。貪欲法とRBMを使った階層的な学習により、深層ニューラルネットワークの学習が現実のものとなり、ディープラーニングの基礎が築かれました。しかし、計算負荷の高さやデータ量の必要性などの限界により、新しい技術の開発が求められ、CNNやRNNといったモデルが登場しました。DBNの登場とその後の発展は、現代のAI技術の基盤を築く重要な一歩となりました。

制限付きボルツマンマシン(Restricted Boltzmann Machine: RBM)の役割

制限付きボルツマンマシン(Restricted Boltzmann Machine: RBM)は、ディープラーニングにおける重要な構成要素の一つです。RBMはニューラルネットワークの一種で、可視層と隠れ層からなる確率的生成モデルです。主にデータの特徴を抽出したり、隠れたパターンを学ぶために使用され、深層信念ネットワーク(Deep Belief Nets: DBN)の基礎を築いています。

RBMの構造

RBMは可視層(visible layer)と隠れ層(hidden layer)の2つの層で構成されます。可視層は入力データを表し、隠れ層はそのデータから抽出される特徴を学習します。各層の間にのみ結合があり、同じ層内には結合がないため「制限付き」と呼ばれています。このシンプルな構造により、効率的な特徴抽出が可能です。

RBMの学習方法

RBMの学習には「コントラスティブ・ダイバージェンス(Contrastive Divergence: CD)」という手法が使われます。この方法は、データから得た情報とモデルが生成したデータの差を最小化しながらパラメータを調整します。ジェフリー・ヒントンによって提案されたこの手法は、RBMの学習を高速化し、ディープラーニングの基盤技術として非常に効果的であることが証明されています。

RBMの役割と重要性

RBMは、ディープラーニングにおいて多くの重要な役割を果たしています。その中でも特に、深層信念ネットワーク(DBN)での層ごとの学習に利用されることが挙げられます。RBMの階層的な学習により、複雑な深層ネットワークを効率的に学習することが可能になります。

特徴抽出の基盤

RBMはデータから隠れた特徴を抽出する基盤として機能します。例えば、画像認識では、RBMが画像のピクセル情報から抽象的な特徴を抽出し、それを次の層に渡します。これにより、各層がデータのパターンを段階的に学習し、複雑な特徴を効率的に把握できます。

層ごとの事前学習

RBMは、深層信念ネットワークにおける「層ごとの事前学習」にも重要な役割を果たします。ジェフリー・ヒントンの研究に基づき、各層をRBMとして順に学習することで、ネットワーク全体の学習効率が向上し、最終的なパフォーマンスが向上します。

RBMの応用

RBMは、多くの応用分野で利用されています。特に、特徴抽出、次元削減、生成モデルとしての利用が代表的です。

次元削減

RBMはデータの次元削減に使われ、複雑なデータを簡略化して扱いやすくします。重要な情報を保持しながら、不要なノイズを除去することで、モデルの学習を効率化し、処理速度を向上させます。

生成モデルとしての利用

RBMは入力データのパターンを学び、そのパターンを基に新しいデータを生成することが可能です。この生成能力は、画像や音声の生成タスクに非常に役立ちます。ヒントンらの研究によれば、この生成モデルはディープラーニングにおける他の手法よりも優れたパフォーマンスを示しています。

まとめ

制限付きボルツマンマシン(RBM)は、ディープラーニングの基盤を支える重要な技術です。RBMは、特徴抽出や層ごとの事前学習を通じて、深層信念ネットワークなどの複雑なモデルの基盤を支える役割を担っています。また、次元削減や生成モデルとしても広く応用され、多くの分野で重要な成果を上げています。ジェフリー・ヒントンらの研究により、RBMの役割はディープラーニングの進化において欠かせないものであり、今後もその技術は多くの分野で活用され続けるでしょう。

ディープラーニングと現在のAI技術への影響

ディープラーニングとは

ディープラーニングは、機械学習の一種で、多層のニューラルネットワークを使ってデータから複雑なパターンを学習する技術です。この技術により、コンピュータは大量のデータから自動的に特徴を抽出し、人間のように推論や判断を行います。特に画像認識、音声認識、自然言語処理など、多くの分野で活用されています。

ディープラーニングの進化

ディープラーニングは2006年にジェフリー・ヒントンらによって開発されました。それ以来、深層信念ネットワーク(DBN)、畳み込みニューラルネットワーク(CNN)、リカレントニューラルネットワーク(RNN)など、さまざまなモデルが登場し、AI技術の基盤として進化を続けています。

現在のAI技術への影響

ディープラーニングは現在のAIに多大な影響を与えています。以下にその主要な分野を紹介します。

画像認識とコンピュータビジョン

ディープラーニングは画像認識とコンピュータビジョンで大きな成果を挙げました。CNNの登場により、物体検出、顔認識、画像分類の精度が大幅に向上し、スマートフォンの顔認証や自動運転技術に活用されています。

音声認識と自然言語処理

音声認識にはRNNやLSTMが使用され、音声からテキストへの変換精度が大幅に向上しました。また、自然言語処理ではTransformerモデルが登場し、翻訳や質問応答などで高い性能を示し、チャットボットや音声アシスタントの発展に寄与しています。

医療分野への応用

医療分野でもディープラーニングは重要な役割を果たしています。CTスキャンやMRI画像の解析によって、疾患の検出精度と診断スピードが向上しました。また、個別化医療の分野でも大きな貢献をしています。

自動運転技術

自動運転の分野では、ディープラーニングがカメラやセンサーから得たデータを処理し、物体や状況を認識する技術として利用されています。これにより、交通事故の減少や効率的な交通システムの実現が期待されています。

ディープラーニングの限界と課題

計算リソースの必要性

ディープラーニングには大量の計算リソースとデータが必要であり、学習には強力なGPUなどのハードウェアが不可欠です。このため、コストが高くなるという課題があります。

データの偏りと倫理的な問題

ディープラーニングは学習に大量のデータを必要としますが、データが偏っているとモデルも偏見を持つ可能性があります。これにより、AIの倫理的な利用が課題となっています。

まとめ

ディープラーニングは現在のAI技術の基盤であり、画像認識、音声認識、自然言語処理、医療、自動運転など多くの分野に影響を与えています。しかし、計算リソースやデータの偏りといった課題もあり、これらを克服することがさらなる技術の発展に必要です。

まとめと今後の展望

まとめ

ディープラーニングは現代のAI技術の進化を支える重要な技術であり、画像認識、音声認識、自然言語処理、医療、自動運転など、多くの分野に大きな影響を与えています。この技術により、私たちの生活はより便利で効率的になっています。ディープラーニングの中心には、多層ニューラルネットワークを使った自動学習があり、AIの性能向上を支えています。

一方で、ディープラーニングには大量のデータや計算リソースが必要であり、強力なハードウェアが不可欠です。また、データの偏りや倫理的な問題も未解決であり、これらの課題を解決することで、公平で効果的なAIシステムを構築する必要があります。

今後の展望

ディープラーニングは今後さらに多くの分野で進化し、新たな応用が期待されています。以下に、いくつかの重要な展望を紹介します。

計算効率の向上

ディープラーニングの課題の一つは計算コストです。今後は、効率的なアルゴリズムや新しいハードウェアの開発によって、計算リソースを抑えながら高精度なモデルの学習が可能になると考えられます。これにより、ディープラーニングの普及がさらに進むでしょう。

少ないデータでの学習

現在のディープラーニングは大量のデータを必要としますが、今後は少ないデータからでも学習できる技術が発展することが期待されています。少数ショット学習(Few-shot learning)やゼロショット学習(Zero-shot learning)は、データが限られている状況でも高い性能を発揮できる方法として注目されています。

説明可能なAI(XAI)の発展

現在のディープラーニングモデルは「ブラックボックス」とされ、判断の理由が理解しづらいという問題があります。説明可能なAI(XAI)の研究が進むことで、AIの判断プロセスがより明確に理解できるようになり、特に医療や法務の分野で信頼性が向上することが期待されます。

マルチモーダルAIの発展

マルチモーダルAIは、画像、音声、テキストなど異なるデータ形式を同時に処理して理解する技術です。この分野は急速に発展しており、例えば、画像と言語を組み合わせた応答生成や、音声と映像から人間の行動を理解するなど、より高度なAIの実現が進んでいます。

最後に

ディープラーニングは今後もAI技術の基盤として重要であり続けるでしょう。技術的な課題はまだ残っていますが、それらを克服することでAIはより多くの問題を解決し、私たちの生活を豊かにする可能性があります。研究者やエンジニアの努力によって、ディープラーニングはさらに進化し、次世代のAI技術を支える基盤となっていくことが期待されます。